🔍 성능을 극대화하려면?

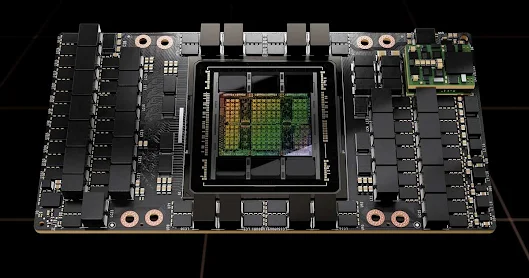

AI 연구, 데이터센터 운영, 고성능 컴퓨팅(HPC)을 위해 강력한 GPU가 필수다.

하지만 2025년 기준 H100과 A100 중 어떤 GPU가 더 우수한 선택일까?

- A100은 여전히 강력하지만, 최신 AI 모델과 LLM(대규모 언어 모델)을 운용하기엔 한계가 있을 수 있다.

- H100은 차세대 성능을 제공하지만, 가격과 전력 소비가 부담일 수 있다.

- 어떤 GPU를 선택하느냐에 따라 모델 훈련 속도, 비용, 운영 효율이 크게 달라진다.

"내 AI 프로젝트에 가장 적합한 GPU는 무엇일까?" 고민된다면, 끝까지 읽어보자.

A100 구매링크

🤝 나도 고민했다! 당신만의 문제가 아니다.

2024년에도 많은 AI 연구자와 기업이 A100을 사용했지만, 점점 더 많은 곳에서 H100으로 전환하고 있다.

- "A100으로도 충분하지 않을까?"

- "H100이 좋다고는 하지만, 가격 대비 성능이 정말 그만한가?"

- "데이터센터 전력 소모를 감당할 수 있을까?"

AI 프로젝트를 진행하면서 예산과 성능 사이에서 균형을 맞추는 것이 얼마나 중요한지 절실히 느꼈다.

그래서 이번 비교를 통해 당신이 최고의 선택을 할 수 있도록 도움을 주겠다.

💡 H100 vs A100 비교 분석

우선, 두 GPU의 핵심 사양을 비교해 보겠다.

| 항목 | H100 | A100 |

|---|---|---|

| 아키텍처 | Hopper | Ampere |

| FP32 성능 | 60 TFLOPS | 19.5 TFLOPS |

| FP16 성능 | 1,000 TFLOPS (Tensor Core) | 312 TFLOPS (Tensor Core) |

| 메모리 용량 | 80GB HBM3 | 80GB HBM2e |

| 대역폭 | 3.35TB/s | 2.0TB/s |

| NVLink 대역폭 | 900GB/s | 600GB/s |

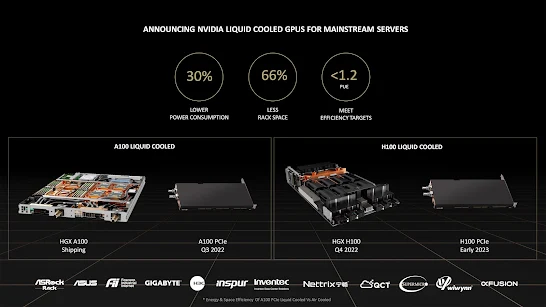

| TDP (소비 전력) | 700W | 400W |

| 도입 비용 | 매우 높음 | 상대적으로 저렴 |

✅ H100의 장점

❌ H100의 단점

- 전력 소모가 크고, 냉각 시스템 필수

- 가격이 A100 대비 상당히 비쌈

✅ A100의 장점

❌ A100의 단점

- H100에 비해 AI 학습 속도가 느림

- HBM2e 메모리로 데이터 처리 속도에서 차이 남

🎯 어떤 GPU를 선택해야 할까?

💡 이렇게 선택하자!

| 상황 | 추천 GPU |

|---|---|

| 최신 LLM, 초거대 AI 모델 학습 | 🚀 H100 |

| 중소규모 AI 연구 및 inference | 🏆 A100 |

| 데이터센터에서 전력 효율이 중요할 때 | ✅ A100 |

| 최상의 성능을 원하고 예산이 충분할 때 | 🔥 H100 |

| 다수의 GPU를 병렬 처리해야 할 때 | 🎯 H100 (NVLink 성능 우수) |

✔ H100이 필요하다면?

- LLM, GPT 모델 등 초고성능 연산이 필수적인 경우

- 기업 AI 솔루션, 대규모 데이터센터 운영

✔ A100이 적합하다면?

- 대학 연구실, 스타트업, 중소 AI 프로젝트

- 적절한 비용으로 효율적인 AI 연산을 원할 때

🔎 이 조건에 맞다면 H100을 선택하자!

- 2025년 이후에도 최고 수준의 AI 모델을 운용할 계획

- 예산이 넉넉하고, 전력 소비가 크더라도 최고의 성능을 원함

- 멀티 GPU 환경에서 확장성이 중요함 (NVLink 성능 차이 큼)

이 조건에 해당되지 않는다면 A100이 더 경제적이고 합리적인 선택일 수 있다.

⏳ 지금 선택해야 하는 이유!

✔ 2025년 현재, A100의 재고가 줄어들고 있다.

✔ H100은 수요가 많아 가격이 점점 오르고 있다.

✔ 기업 및 연구소에서는 이미 H100 도입을 서두르고 있다.

🔥 당신의 프로젝트에 최적의 GPU를 선택하자!

👉 지금 구매하기 전에 H100과 A100의 최신 가격을 확인하자!

📌 H100 vs A100, 2025년 최고의 선택은?

✔ 최고 성능이 필요하면 H100

✔ 가성비가 중요하면 A100

당신의 AI 프로젝트에 딱 맞는 GPU를 선택하고, 한 단계 더 성장하자.

Tags:

AI